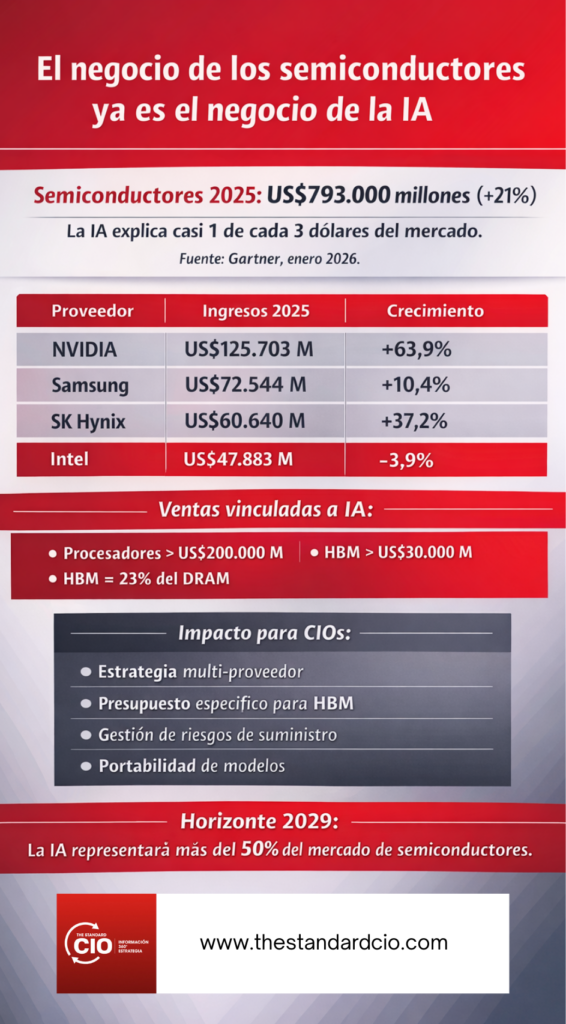

Gartner confirma un mercado de US$793.000 millones en 2025: NVIDIA rompe la barrera de los US$100.000 millones y la memoria HBM se convierte en el nuevo cuello de botella estratégico.

El mercado mundial de semiconductores creció 21% en 2025 y alcanzó US$793.000 millones, según Gartner. NVIDIA se convirtió en el primer fabricante en superar los US$100.000 millones en ingresos y amplió su ventaja sobre Samsung en US$53.000 millones. Los componentes directamente ligados a inteligencia artificial —procesadores, memoria de alto ancho de banda (HBM) y chips de red— ya representan casi un tercio de todas las ventas y los procesadores de IA superaron los US$200.000 millones. Para los CIO el mensaje es inequívoco: la conversación sobre infraestructura dejó de ser técnica y se volvió estructuralmente financiera y estratégica.

Qué es este artículo y para qué te sirve

Esto es una noticia contextualizada a partir del informe preliminar Market Share Analysis: Semiconductors, Worldwide, 2025 de Gartner. En dos minutos deberías quedarte con tres ideas:

-

la IA está rediseñando la cadena de valor del hardware,

-

el poder se concentra en muy pocos proveedores,

-

los presupuestos de TI ya no pueden planificarse con lógica de cómputo tradicional.

La pregunta que debería hacerse cualquier CIO hoy es directa: ¿mi estrategia de nube y centros de datos está preparada para un mundo donde la memoria y los aceleradores son más críticos que los servidores?

Qué se ha anunciado

Qué se ha anunciado

Los datos de Gartner muestran un reordenamiento claro del ranking mundial:

-

NVIDIA lideró con US$125.703 millones y 15,8% del mercado, creciendo 63,9%.

-

Samsung Electronics quedó segunda con US$72.544 millones; la memoria subió 13% pero su negocio no-memoria cayó 8%.

-

SK Hynix saltó al tercer lugar con US$60.640 millones (+37,2%) impulsada por la demanda de HBM para servidores de IA.

-

Intel siguió perdiendo terreno y cerró con solo 6% de cuota, la mitad que en 2021.

Un dato define la tendencia: la HBM ya es 23% del mercado DRAM y superó los US$30.000 millones.

HBM (High Bandwidth Memory) es una memoria de alto rendimiento diseñada para trabajar pegada físicamente a las GPUs y aceleradores de IA. A diferencia de la memoria tradicional de los servidores, la HBM está apilada en 3D y conectada mediante interposers de alta velocidad, lo que permite mover volúmenes masivos de datos con una latencia mínima y un consumo energético mucho menor por bit transferido. En términos simples, no acelera “el cerebro” del sistema, sino el flujo de información que lo alimenta, y en los modelos de IA ese flujo es tan crítico como el propio procesador.

Por eso la HBM se ha convertido en el verdadero cuello de botella de la inteligencia artificial. Entrenar o ejecutar modelos de gran escala exige leer y escribir parámetros a una velocidad que la memoria DDR convencional no puede sostener. De ahí que solo tres fabricantes —SK Hynix, Samsung y Micron— concentren hoy un mercado que ya supera los US$30.000 millones y representa el 23% del negocio DRAM. Para los CIO, esto significa que la disponibilidad y el precio de la HBM empiezan a definir plazos, arquitecturas y hasta la viabilidad financiera de los proyectos de IA.

Gartner estima que el gasto en infraestructura de IA superará US$1,3 billones en 2026. No hablamos de un pico coyuntural, sino de un cambio de centro de gravedad. Las empresas están moviendo cargas críticas hacia nubes especializadas, entrenando modelos propios y exigiendo inferencia en tiempo real.

¿Resultado? La capacidad de cómputo se vuelve un problema de negocio. No es solo cuánto inviertes, sino a quién le compras, bajo qué contratos y con qué margen de negociación.

Primeras implicaciones para los CIOs

-

Estrategia: la dependencia de un único proveedor ya es un riesgo corporativo, no solo técnico.

-

Inversión: HBM y redes de baja latencia deben presupuestarse como categorías propias.

-

Riesgos: volatilidad de precios y concentración del mercado.

-

Arquitectura: portabilidad de modelos y enfoque multi-cloud dejan de ser buenas prácticas y se vuelven seguros de vida.

La cuestión no es si usarás IA, sino cuánto te costará operarla y qué tan expuesto quedarás a la cadena de suministro.

El mercado de semiconductores camina hacia un escenario donde la IA representará más del 50% de las ventas en 2029. Seguiremos el tema con foco en compras tecnológicas, gobierno del gasto y arquitectura híbrida. Esto no es el final de la historia: es el capítulo uno.