NVIDIA Blackwell GB200 NVL72 acelera 10x modelos Mixture of Experts, arquitectura adoptada por 60% de lanzamientos IA en 2025 y presente en top 10 mundial.

La arquitectura Mixture of Experts (MoE) se ha consolidado como estándar técnico en modelos de inteligencia artificial frontier, dominando los primeros 10 puestos de modelos open-source más inteligentes según el ranking independiente Artificial Analysis. DeepSeek-R1 de DeepSeek AI, Kimi K2 Thinking de Moonshot AI, gpt-oss-120B de OpenAI y Mistral Large 3 de Mistral AI encabezan esta clasificación basada en arquitectura MoE.

NVIDIA reporta que su sistema GB200 NVL72 genera mejoras de rendimiento 10x comparado con la plataforma HGX H200 en estos modelos. Esta aceleración redefine la economía de implementación de IA en centros de datos con restricciones energéticas y presupuestarias, permitiendo 10x el ingreso por token generado.

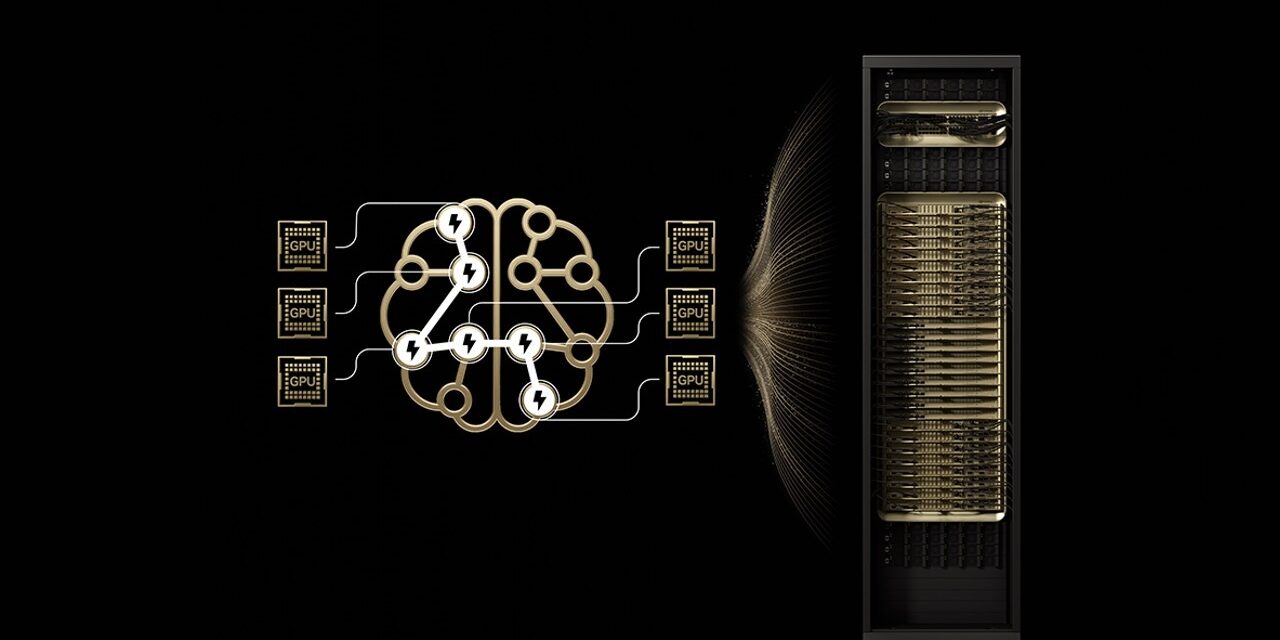

La arquitectura MoE replica la eficiencia del cerebro humano dividiendo el trabajo entre “expertos” especializados. Mientras el cerebro activa regiones específicas según la tarea cognitiva, los modelos MoE utilizan un router que selecciona únicamente los expertos relevantes para cada token de IA. Esta selectividad genera tokens más rápidamente sin incremento proporcional en capacidad de cómputo.

El 60% de los lanzamientos de modelos open-source en 2025 adoptaron arquitectura MoE. Desde principios de 2023, esta tecnología ha permitido un incremento de 70x en inteligencia de modelos, empujando los límites de capacidad en IA. Modelos densos tradicionales utilizan todos sus parámetros —frecuentemente cientos de miles de millones— para generar cada token, demandando potencia computacional y energía inmensas que dificultan escalabilidad.

“Nuestro trabajo pionero con arquitectura OSS mixture-of-experts, iniciando con Mixtral 8x7B hace dos años, garantiza que inteligencia avanzada sea accesible y sostenible para aplicaciones amplias”, afirmó Guillaume Lample, cofundador y científico principal de Mistral AI. “La arquitectura MoE de Mistral Large 3 permite escalar sistemas de IA a mayor rendimiento y eficiencia mientras reducimos dramáticamente demandas de energía y cómputo”.

Superación de cuellos de botella mediante codesign extremo

Los modelos MoE frontier son demasiado grandes para desplegarse en una GPU individual. La distribución de expertos entre múltiples GPUs —técnica denominada paralelismo de expertos— enfrenta limitaciones críticas incluso en plataformas potentes como NVIDIA H200:

Limitaciones de memoria: Las GPUs deben cargar dinámicamente parámetros de expertos seleccionados desde memoria de alto ancho de banda para cada token, generando presión constante sobre ancho de banda de memoria.

Latencia: Los expertos ejecutan comunicación all-to-all casi instantánea para intercambiar información y formar respuestas completas. En H200, distribuir expertos entre más de ocho GPUs requiere comunicación sobre redes scale-out de mayor latencia, limitando beneficios del paralelismo de expertos.

NVIDIA GB200 NVL72 constituye un sistema rack-scale con 72 GPUs Blackwell funcionando como unidad integrada, entregando 1.4 exaflops de rendimiento de IA y 30TB de memoria compartida rápida. Las 72 GPUs se conectan mediante NVLink Switch en una única fabric de interconexión NVLink masiva, permitiendo comunicación entre cualquier GPU con 130 TB/s de conectividad NVLink.

Esta arquitectura resuelve cuellos de botella de escalamiento MoE mediante:

Reducción de expertos por GPU: Distribuir expertos entre 72 GPUs reduce expertos por GPU, minimizando presión de carga de parámetros sobre memoria de alto ancho de banda de cada GPU. Menos expertos por GPU libera espacio de memoria, permitiendo servir más usuarios concurrentes y soportar longitudes de entrada mayores.

Aceleración de comunicación entre expertos: Los expertos distribuidos entre GPUs se comunican instantáneamente usando NVLink. NVLink Switch posee capacidad de cómputo para ejecutar cálculos requeridos para combinar información de diversos expertos, acelerando entrega de respuestas finales.

Validación de rendimiento en modelos líder

Kimi K2 Thinking —clasificado como modelo open-source más inteligente en el ranking AA— registra salto de rendimiento 10x en GB200 NVL72 comparado con HGX H200. Este incremento no es métrica aislada: transforma economía de IA a escala en centros de datos con restricciones.

Fireworks AI desplegó Kimi K2 en plataforma NVIDIA B200 para alcanzar el rendimiento más alto en el leaderboard Artificial Analysis. “El diseño rack-scale de NVIDIA GB200 NVL72 hace el serving de modelos MoE dramáticamente más eficiente”, señaló Lin Qiao, cofundador y CEO de Fireworks AI. “NVL72 tiene potencial para transformar cómo servimos modelos MoE masivos, entregando mejoras importantes sobre la plataforma Hopper”.

DeepSeek-R1 y Mistral Large 3 lograron ganancias de rendimiento 10x en GB200 NVL72 comparado con H200. Esta ganancia generacional se traduce en mejor experiencia de usuario, menor costo por token y mayor eficiencia energética.

El framework NVIDIA Dynamo orquesta serving desagregado asignando tareas de prefill y decode a GPUs diferentes. Frameworks open-source de inferencia como NVIDIA TensorRT-LLM, SGLang y vLLM soportan estas optimizaciones para modelos MoE.